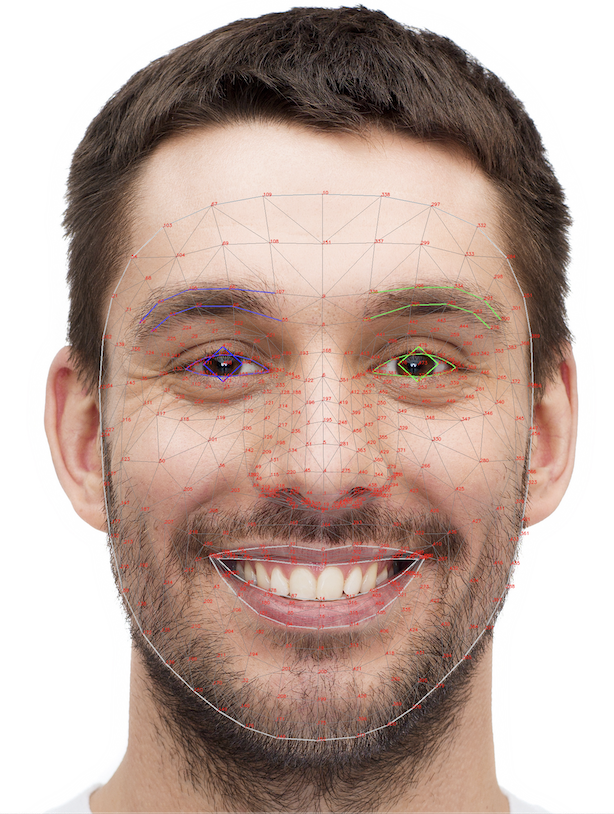

01 顔にある「468個の点」

出典: Google MediaPipe Developers

私たちが使っている「MediaPipe Face Landmarker」というAIは、カメラ映像から顔を見つけると、その上に**468個の点(ランドマーク)**を打ちます。

目頭、鼻の頭、唇の端、あごのライン...。

これらの位置がリアルタイムに数値(X座標, Y座標, Z座標)として計算されます。これにより、AIは「顔の地図」を手に入れるのです。

02 どうやって「顔の向き」を知る?

顔の向きを調べるもっとも簡単な方法は、**「鼻」の位置**を見ることです。

正面

鼻が顔の真ん中にある

右向き

鼻が右に寄る

上向き

鼻が上に寄る

「Xevious風ゲーム」のFace Controlモードでは、

「**キャリブレーション(基準点設定)**」を行った瞬間の鼻の位置を「中心(動きなし)」とします。

そこから鼻がどれだけズレたかを計算し、マウスカーソルの移動量に変換しています。これがハンズフリー操作の正体です。

03 表情でスイッチを押す

位置だけでなく、**「Blendshapes(ブレンドシェイプ)」**という数値も取得できます。これは「表情筋のパラメータ」です。

eyeBlinkLeft: 左目を閉じる強さ (0.0〜1.0)jawOpen: 口を開ける大きさ (0.0〜1.0)browDownLeft: 眉を下げる強さ (0.0〜1.0)

これを「もし 0.5 以上ならスイッチON」とプログラムすることで、身体が動かせなくてもまばたきや口の動きだけでクリック操作が可能になります。

「座標」と「表情」の組み合わせ。

それが新しいインターフェースを作る魔法です。